۱٫ معرفی

با پیشرفت جامعه، دفع مکرر محصولات ممتاز و روزمره یک تهدید زیستمحیطی قابل توجهی ایجاد میکند و ضرورت استفاده از شیوههای پایدار در مدیریت چرخه عمر محصول را برجسته میکند. دفع مستقیم چنین محصولاتی نه تنها به طور قابل توجهی به آلودگی محیط زیست کمک می کند، بلکه منابع محدود را نیز کاهش می دهد و مسائل زیست محیطی را تشدید می کند که زندگی روزمره مردم را مختل می کند. از بین بردن این محصولات با تمرکز بر استخراج اجزای با ارزش پایان عمر (EOL) که به کاهش آلودگی محیط زیست کمک می کنند ضروری می شود. [

۱]. با این حال، برای پرداختن واقعی به اثرات زیست محیطی دفع محصول، یک رویکرد جامع که ریشه در اصول پایدار دارد ضروری است.

پذیرفتن اصول پایدار در جداسازی محصول شامل بیش از استخراج اجزای ارزشمند است. این امر مستلزم اتخاذ استراتژی هایی است که بهره وری منابع، کاهش ضایعات و حفظ محیط زیست را در کل چرخه عمر محصول در اولویت قرار می دهد. با بهینه سازی فرآیندهای جداسازی قطعات و ترویج استفاده مجدد از اجزای EOL، نه تنها می توان آلودگی زیست محیطی را به حداقل رساند، بلکه می توان منابع ارزشمند را نیز حفظ کرد. [

۲]. این تغییر به سمت شیوههای جداسازی قطعات پایدار با هدف کلی مدیریت منابع پایدار و حفاظت از محیط زیست همسو میشود، که نشاندهنده تعهد به حفظ اکوسیستمها و ارتقای رفاه اجتماعی درازمدت است.

گنجاندن ملاحظات پایدار در مشکل تعادل خط جداسازی قطعات برای دستیابی به مزایای زیست محیطی پایدار ضروری است. با بهینه سازی فرآیندهای جداسازی قطعات برای به حداکثر رساندن بازیابی منابع و به حداقل رساندن تولید ضایعات، تولیدکنندگان می توانند به یک مدل اقتصاد دایره ای کمک کنند که در آن منابع به طور موثرتری استفاده می شود و اثرات زیست محیطی به حداقل می رسد. علاوه بر این، با افزایش طول عمر محصولات از طریق جداسازی قطعات و استفاده مجدد از قطعات، می توان نیاز به استخراج مواد خام و تولید کالاهای جدید را کاهش داد و روش های پایدار را بیشتر پیش برد و تخریب محیط زیست را کاهش داد. [

۳].

در دوران معاصر، تشدید نگرانیها در مورد آلودگی، اتخاذ تدابیر مؤثری را برای کاهش تأثیر آن و همسویی با اصول پایداری برانگیخته است. یکی از این رویکردها شامل جداسازی و پردازش مجدد محصولات قابل بازیافت است که نه تنها آلودگی را کاهش می دهد، بلکه باعث حفظ منابع ارزشمند و ارتقای پایداری زیست محیطی می شود. این امر مستلزم پرداختن به مشکل تعادل خط جداسازی است، که تغییراتی را در سناریوهای مختلف دنیای واقعی نشان میدهد. معیارهای مختلفی از جمله به حداکثر رساندن درآمد، به حداقل رساندن زمان جداسازی قطعات، و بهینهسازی شاخص صافی ایستگاه کاری، در میان سایر موارد، در شیوههای جداسازی قطعات پایدار نقش دارند. فرموله کردن یک مدل ریاضی مناسب بر اساس موقعیتهای خاص امکان حل هدفمند مشکل تعادل خط جداسازی مرتبط را فراهم میکند و ملاحظات پایداری را در فرآیندهای تصمیمگیری ادغام میکند.

مجموعهای از روشهای جداسازی وجود دارد که شامل جداسازی کامل و جزئی، همراه با رویکردهای مخرب و غیر مخرب است. [

۴]. خطوط جداسازی قطعات مختلف، مانند پیکربندی های خطی، دوطرفه، موازی و U شکل، رویکردهای متمایزی را ارائه می دهند که هر کدام پیامدهای خاص خود را برای پایداری دارند. طراحی خطوط جداسازی قطعات خاص برای تأسیسات مختلف، بررسی مشکلات تعادل را تسهیل میکند و در عین حال اطمینان میدهد که شیوههای پایدار در طول فرآیند رعایت میشوند. در حال حاضر، اکتشاف گسترده ای از خطوط مختلط در بخش های مختلف جامعه وجود دارد که منعکس کننده شناخت روزافزون اهمیت پایداری در شیوه های صنعتی است. با توجه به تنوع محصولات قابل بازیافت و ضرورت افزایش شیوه های جداسازی و بازیافت، اجرای روش های خط جداسازی مختلط، ادغام پیکربندی های خطی و U شکل، مورد توجه قرار گرفته است. این تلاش با هدف خدمت رسانی بهتر به جامعه، پاکسازی محیط زیست و کمک به ایجاد یک اکوسیستم سبز، همسو با اهداف کلی توسعه پایدار و ترویج مدل اقتصاد دایره ای است.

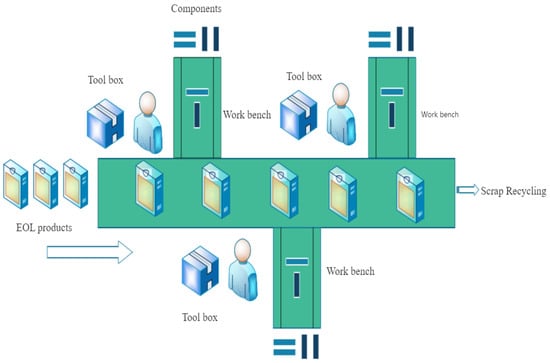

در این مقاله، تمرکز ما بر روی حل مشکل تعادل خط جداسازی دو طرفه (DLBP) است. [

۵,

۶]. طرح معمولی یک خط جداسازی قطعات در به تصویر کشیده شده است

شکل ۱. ادبیات مربوط به خطوط جداسازی قطعات دو طرفه، به ویژه در حوزه همکاری انسان و ربات، پراکنده است. علاوه بر این، تحقیقات کمی برای استفاده از یادگیری تقویتی برای مقابله با این مشکل خاص وجود دارد. کار قبلی توسط Xie و همکاران. [

۷] DLBP دو طرفه را با محدودیتهایی در ایستگاههای کاری و مصرف انرژی در نظر گرفت و از یک الگوریتم تکاملی دیفرانسیل برای حل DLBP دو طرفه چند هدفه استفاده کرد. با این حال، این روش برای مشکلات پیوسته مناسب تر است، در حالی که DLBP ذاتا گسسته است. در نتیجه، تبدیل به یک الگوریتم گسسته برای حل موثر مسئله ضروری است. وانگ و همکاران [

۸] مدل سازی بر اساس خطوط جداسازی دو طرفه را بررسی کرد و راه حلی را با استفاده از الگوریتم ژنتیک با جستجوی همسایگی متغیر پیشنهاد کرد و سرعت همگرایی الگوریتم را افزایش داد. اثر دیگری از وانگ و همکاران. [

۹] به مدلسازی و راهحلهای DLBP پرداخته و مواردی را بررسی میکند که شامل زمانهای جداسازی نامشخص، زمان ضربات نامشخص، طرحبندی الگوی دو طرفه، و وجود موانع جداسازی قطعات بین قطعات است. آنها از یک الگوریتم کلونی زنبورهای مصنوعی ترکیبی همراه با استراتژی جستجوی متغیر همسایگی عمق استفاده کردند. ژائو و همکاران [

۱۰] DLBP موازی را با در نظر گرفتن انتشار کربن مطالعه کرد، یک مدل جداسازی قطعات مبتنی بر گراف هیبریدی ایجاد کرد و از یک الگوریتم ژنتیک برای حل مشکل استفاده کرد. با این حال، این مطالعات همکاری انسان و ربات را در نظر نمی گیرند، در درجه اول بر روی چند هدف متمرکز هستند که با حل کننده CPLEX قابل بررسی نیستند و از الگوریتم های اکتشافی استفاده می کنند. بنابراین، مدل ما در این مقاله، همکاری انسان و ربات را برای فرمولبندی یک مدل متناظر ادغام میکند، و الگوریتم از تکنیکهای رایج یادگیری تقویتی رایج برای رسیدگی موثر به مشکل استفاده میکند.

بسیاری از مقالات موجود به الگوریتمهای هوشمند مانند الگوریتم کلونی زنبورهای مصنوعی، الگوریتم تکامل تفاضلی نخبگان و موارد دیگر برای رسیدگی به مشکل تعادل خط جداسازی (DLBP) متوسل میشوند. [

۱۱]. اگرچه این الگوریتمها میتوانند راهحلهای بهینه را ارائه دهند، اما اغلب به تکرارهای متعددی نیاز دارند که به طور بالقوه منجر به بیثباتی در نتایج نهایی میشوند. در این مقاله، ما از یک الگوریتم یادگیری تقویتی از یادگیری ماشین برای رسیدگی به تعادل خط جداسازی در مقیاسهای کوچک، متوسط و بزرگ استفاده میکنیم. یادگیری تقویتی، که در حال حاضر به عنوان یک روش هوش مصنوعی کارآمدتر شناخته شده است [

۱۲]، به عنوان انتخاب ترجیحی برای حل DLBP در جداسازی انتخابی ظاهر می شود، که دستیابی سریعتر به راه حل های بهینه را تضمین می کند و در نتیجه کارایی را افزایش می دهد. با توجه به افزایش توجه جامعه به DLBP، تعداد زیادی از الگوریتمها در این حوزه با تأکید فزاینده بر کارایی ارائه راهحلهای بهینه اعمال میشوند. یادگیری تقویتی به طور گسترده در مسائل برنامه ریزی مسیر مورد استفاده قرار گرفته است [

۱۳,

۱۴]. به طور همزمان، ادغام خطوط یادگیری تقویتی و جداسازی قطعات، علاقه فزاینده ای را از دانشگاه و صنعت به یکسان جلب کرده است. [

۱۵,

۱۶]. در این مقاله، ما از الگوریتم یادگیری Q برای پرداختن به DLBP و اعتبارسنجی نتایج الگوریتمی با حل مدل ریاضی مربوطه با CPLEX استفاده میکنیم. نتایج نشان می دهد که الگوریتم یادگیری Q سرعت حل سریع را نشان می دهد و راه حل های بهینه را ارائه می دهد.

مشارکت های این مقاله در درجه اول در جنبه های زیر خلاصه می شود:

(۱) یک مدل برنامه نویسی عدد صحیح مختلط مربوطه ایجاد شده است. راهحلهای موجود برای مشکل متعادلسازی خط جداسازی قطعات اغلب شامل فرمولبندیهای چند محصولی و چند هدفه است که چالشهایی را برای حلکنندههایی مانند CPLEX ایجاد میکند. این مقاله یک مدل ریاضی خطی تک هدفه را اتخاذ میکند، که یک راهحل با CPLEX را تسهیل میکند، بنابراین تأیید دقیق و کاهش خطاهای احتمالی را تضمین میکند.

(۲) یک رویکرد یادگیری تقویتی برای حل DLBP، روشی که کمتر در شیوه های فعلی استفاده می شود، معرفی شده است. یک جدول Q جدید تعریف شده است که الگوریتم را قادر می سازد تا محیط را بر اساس تابع هدف یاد بگیرد.

(۳) دقت مدل ابتدا با CPLEX تایید میشود و سپس نتایج الگوریتمی با نتایج بدست آمده از CPLEX مقایسه میشود. این فرآیند اعتبارسنجی دو مرحله ای قابلیت اطمینان الگوریتم پیشنهادی را تضمین می کند و از احتمال شکست در شناسایی راه حل بهینه محافظت می کند.

بخشهای بعدی این مقاله به گونهای طراحی شده است که درک جامعی از تحقیق ما ارائه دهد. که در

بخش ۲، ما شرح مفصلی از مسئله را همراه با فرمول بندی مدل برنامه نویسی عدد صحیح مختلط ارائه می دهیم. علاوه بر این، ما تصاویر مربوطه را برای توضیح دقیق فرآیند ارائه می دهیم. حرکت به سوی

بخش ۳ ما به اصول الگوریتم یادگیری Q می پردازیم و روش الگوریتمی آن را توضیح می دهیم. این بخش به ویژه بر استفاده از الگوریتم یادگیری Q برای رسیدگی موثر به مشکل تعادل خط جداسازی (DLBP) تأکید می کند. که در

بخش ۴، نتایج به دست آمده را با استفاده از الگوریتم خود به طور کامل تجزیه و تحلیل کرده و آنها را با نتایج به دست آمده با استفاده از حل کننده CPLEX مقایسه می کنیم. هدف این تحلیل مقایسه ای نشان دادن عملکرد الگوریتم ما است. سرانجام،

بخش ۵ به عنوان بخش پایانی این مقاله عمل می کند و یافته ها و مشارکت های کلیدی ارائه شده در بخش های قبل را خلاصه می کند.

۳٫ الگوریتم و کاربرد Q-Learning

۳٫۱٫ شرح الگوریتم Q-Learning

این بخش به معرفی اصول و فرآیندهای الگوریتم یادگیری Q می پردازد [

۱۹,

۲۰,

۲۱]. الگوریتم یادگیری کیو روشی است که به طور گسترده در یادگیری تقویتی مورد استفاده قرار می گیرد، با یک مثال معمول استفاده از آن برای اکتشاف ماز برای یافتن گنج است. [

۲۲,

۲۳]. در حوزه یادگیری تقویتی، عامل هوشمند به طور مداوم با یک محیط ناشناخته تعامل دارد. دو مفهوم اساسی یعنی حالت و عمل معرفی شده است. عامل اقداماتی را با مقادیر متناظر انجام می دهد تا به طور مداوم پاداش را به حداکثر برساند. الگوریتم یادگیری Q برای ذخیره اطلاعات آموخته شده در مورد محیط با استفاده از یک جدول Q استفاده می شود. در هر تکرار، عمل با بالاترین مقدار Q در حالت فعلی برای انتقال حالت انتخاب می شود. عامل اقدام می کند

بر اساس وضعیت فعلی

. یک مقدار عمل با هر عمل مربوطه مرتبط است [

۲۴]. مقادیر بازگشتی متفاوتی بر اساس انتقال حالت و اقدام انجام شده توسط عامل به دست می آید. این مقادیر بازگشتی پس از یادگیری جامع محیط در جدول Q ذخیره می شوند و به عامل اجازه می دهند تا اقدام مناسب را برای انتقال حالت انتخاب کند.

در یادگیری تقویتی، مفهوم اساسی این است که عامل را قادر به تعامل با محیط برای جمع آوری اطلاعات می کند. هنگامی که عامل به یک وضعیت خاص می رسد، اطلاعات در آن حالت ثبت می شود. این امر انتخاب بهتر ایالت ها و اقدامات در محیط گسترده تر را در آینده تسهیل می کند. اساساً، یادگیری تقویتی شامل فرآیند مستمر اجازه دادن به عامل هوشمند برای کشف و مرتکب اشتباه می شود. همانطور که عامل تجربه کافی را جمع آوری می کند، به عنوان نشان داده شده است

E، در الگوریتم یادگیری Q، این به به روز رسانی مداوم مقادیر در جدول Q ترجمه می شود. [

۲۵,

۲۶].

ایده اصلی الگوریتم یادگیری به شرح زیر است:

ماهیت این فرمول در معادله بلمن نهفته است، که نشان دهنده رابطه تبدیل جفت ارزش-عمل است. به عنوان هدف تفاوت زمانی (TD) نامیده می شود، که در آن نشان دهنده انحراف TD است که معمولاً به عنوان خطای TD شناخته می شود. اینجا، نشان دهنده میزان یادگیری است و ضریب زوال پاداش است. این فرمول با استفاده از روش TD به روز رسانی می شود و آن را در دسته الگوریتم های TD قرار می دهد.

معادله فوق فرمول به روز رسانی یادگیری Q را تشکیل می دهد. این به حالت بعدی متکی است، جایی که بزرگترین مقدار Q برای عمل انتخاب می شود، ضرب در فروپاشی

، و به مقدار بازگشتی واقعی مطابق با واقعی ترین مقدار Q اضافه می شود. به روز رسانی بر اساس

از جدول Q قبلی، به عنوان یک تخمین Q-value عمل می کند. از طریق این فرمول، ما به طور مداوم اطلاعات را از محیط استخراج می کنیم و مقادیر Q را در موقعیت های مربوط به جدول Q بر اساس اطلاعات به دست آمده اعم از مثبت یا منفی به روز می کنیم. معادله بلمن تابع مقدار حالت را در اعمال این الگوریتم درگیر می کند که به صورت زیر نشان می دهیم:

معادله بلمن برای این تابع حالت به صورت بیان شده است

تابع حالت، مقدار حالت فعلی را نشان میدهد، نه تنها مقدار حالت خود، بلکه مجموع مقادیر از همه حالتهایی را که میتوان در مراحل بعدی به آنها رسید، در نظر گرفت. در هر مرحله، ما در یک ضریب فروپاشی ضرب می کنیم ، نشان دهنده نسبت مقادیر حالت بعدی است. بزرگتر حاکی از تأثیر بیشتر مقادیر حالت بعدی بر روی مقدار Q در جدول Q ما است و بر اهمیت آنها تأکید می کند. این به ما اجازه می دهد تا تابع مقدار حالت بهینه را که با نشان داده می شود استخراج کنیم ، بر اساس تابع حالت.

اعمال این تعریف از تابع حالت در زمینه خط جداسازی ما شامل کم کردن زمان جداسازی قطعات از ۱۰۰ برای هر موقعیت است. این تبدیل تضمین می کند که مقادیر زمانی کوچکتر با مقادیر بزرگتر در جدول Q مطابق روش یادگیری مطابقت دارد. در نهایت، دنباله جداسازی قطعات بهینه بر اساس استراتژی حریصانه به دست می آید.

شبه کد برای الگوریتم یادگیری Q در الگوریتم ۱ نشان داده شده است.

| الگوریتم ۱: الگوریتم یادگیری Q |

| ورودی: س(س، آ)، برای همه س ∈ اس، آ ∈ آ، خودسرانه و س(حالت پایانی،-) = ۰، a، c |

| خروجی: جدید س(س، آ) |

| تکرار (برای هر قسمت): |

| مقدار دهی اولیه کنید اس |

| تکرار (برای هر مرحله از قسمت): |

| انتخاب کنید آ از جانب اس با استفاده از خط مشی ناشی از س (به عنوان مثال، e- حریص) |

| اقدام به آ، رعایت کنید آر، اس“ |

| س(اس، آ) ← س(اس، آ) + الف[R + γmaxaQ(S′, a) − Q(S, A)] |

| اس ← اس“ |

| تا زمان اس ترمینال است |

الگوریتم مدل را با هدف انتخاب عمل با حداکثر مقدار برای حالت بعدی تکرار می کند.

انتخاب عمل برای حالت بعدی با استفاده از الگوریتم حریص، قرار دادن آن در دسته الگوریتم های یادگیری آفلاین. با انتخاب حداکثر مقدار عمل به عنوان مقدار هدف، جهت به روز رسانی ارزش به سمت بهینه هدایت می شود .

این رویکرد بر تابع مقدار متکی است و محاسبات تکرار را از طریق تابع ارزش تسهیل می کند. با پیروی از استراتژی بهینه سازی بر اساس تابع مقدار که در بالا توضیح داده شد، عمل مربوط به مقدار بهینه را به دست می آوریم.

۳٫۲٫ Q-Learning همراه با خطوط جداسازی قطعات

با توجه به توضیحات فوق، واضح است که الگوریتم برای حل مسائل گسسته مناسب است و مسئله تعادل خط جداسازی (DLBP) ذاتاً یک مسئله گسسته است. بنابراین، الگوریتم در واقع برای حل DLBP قابل استفاده است. هدف این مقاله به طور خاص به حداقل رساندن زمان جداسازی کل است. تبدیل ریاضی مقادیر زمان کوچک به مقادیر نسبتاً بزرگ به الگوریتم اجازه می دهد تا به طور مؤثر حالتی را با زمان کمتر در هر مرحله انتخاب کند و با تابع هدف همسو شود. برای ادغام نمودار وظیفه AND/OR در یادگیری تقویتی، مجموعه اقدامات قابل انتخاب را به عنوان مجموعه بعدی از حالت هایی که وضعیت فعلی می تواند به آنها برسد، در نظر می گیریم. متعاقباً، الگوریتم به حل مشکل خط جداسازی میپردازد و مراحل بر اساس فلوچارت الگوریتم فوق به تفصیل در زیر توضیح داده میشوند.

مرحله ۱:

جدول Q را با ساخت یک آرایه دو بعدی با n ستون ها و متر ردیف ها ستون ها تعداد اقدامات را نشان می دهند و ردیف ها تعداد حالت ها را نشان می دهند. مقدار هر موقعیت در این آرایه دو بعدی در ابتدا ۰ تنظیم شده است. با توجه به نمودار DLBP و AND/OR، ما وضعیت را بر روی وظیفه تخریب و عمل را برای کار بعدی تنظیم می کنیم. بنابراین، جدول Q یک آرایه مربع است.

گام ۲:

با انتخاب یک عمل در حالت S مطابق جدول Q یک عمل را انتخاب کنید. با این حال، در همان ابتدا، هر Q-value روی ۰ تنظیم می شود. مقادیر حالت قابل دستیابی از این حالت، با توجه به ویژگی های DLBP، به مقادیر پاداش مربوطه تنظیم می شوند. در ابتدا، عامل محیط را بررسی می کند و به طور تصادفی اقداماتی را انتخاب می کند. این به این دلیل است که عامل در این زمان هیچ چیز در مورد محیط نمی داند. همانطور که عامل به کاوش در محیط ادامه می دهد، احتمال انتخاب تصادفی کاهش می یابد، یعنی عامل قادر به یادگیری در مورد محیط است.

مرحله ۳:

یک عمل را اجرا کنید. در مسئله تعادل خط جداسازی، این با قابل دسترس بودن همه حالت ها شروع می شود، بنابراین یک کار تصادفی برای انجام انتخاب می شود. در فرآیند کاوش مداوم، تخمین عامل از مقدار Q بیشتر و دقیق تر می شود، یعنی پس از تعداد معینی کاوش، الگوریتم می تواند جواب بهینه را پیدا کند.

مرحله ۴:

ارزیابی کنید. حال که عمل انجام شد و نتیجه و پاداش مشاهده شد، تابع اکنون باید طبق الگوریتم به روز شود. در نهایت، پس از اتمام مراحل اکتشاف از پیش تعیین شده، عامل اکنون آماده بهره برداری از محیط است. در این مرحله، جدول Q را به دست می آوریم که نشان دهنده مقادیر Q بهینه است. عامل اکنون اقدامات بهتری را انتخاب می کند و در این مرحله، زیرنویس مربوط به بزرگترین مقدار در یک ردیف از جدول Q عمل بهینه برای وضعیت فعلی است. با توجه به مدل ذکر شده در این مقاله، الگوریتم زمانی متوقف می شود که معیار بهره برآورده شود، که زمانی رخ می دهد که عامل یک انتقال حالت را کامل کند.

شکل ۴ با استفاده از مثال مونتاژ دستگاه کپی که در این مقاله حل شده است، تکامل مقادیر Q برای حالت های قابل دسترسی در جدول Q مربوط به حالت ۰ را به تصویر می کشد. مطابق با رویکرد ارائه شده در این مقاله، وظیفه ساخته شده ۰ می تواند از طریق نمودار AND/OR به وظایف ۱، ۲، ۱۶ و ۲۸ برسد. نمودار تکرار شونده Q-values این ارتباط را منعکس می کند. با مشاهده نمودار تکراری، آشکار می شود که ثبات تقریباً در حدود ۲۵۰۰ مرحله تمرینی است و حالت نهایی ۱ به بالاترین مقدار Q می رسد. در نتیجه، ما تصمیم میگیریم که فرآیند جداسازی قطعات را با کار ۱ آغاز کنیم.

در ادامه نحوه بهبود الگوریتم یادگیری Q برای حل DLBP با استفاده از مثال نمودار ماشین لباسشویی AND/OR از مقاله ذکر شده قبلی توضیح داده شده است.

در الگوریتم اصلی یادگیری Q، جدول Q مقداردهی اولیه می شود تا الگوریتم را در مورد چگونگی رسیدن به مقصد راهنمایی کند. مقادیر اولیه برای حالتهای قابل دسترسی ۱، برای حالتهای غیرقابل دسترس −۱ و برای رسیدن به مقصد ۱۰۰ تنظیم میشوند. ما یک جدول اولیه را بر اساس این رابطه منطقی می سازیم و تعداد کل مراحل یادگیری را بر اساس اصل تکرار ارزش تنظیم می کنیم و در نهایت جدول Q را پس از یادگیری بدست می آوریم. با این حال، این رویکرد یک مقصد روشن را فرض میکند و برای مشکل ما مناسب نیست زیرا الگوریتم نباید تنها زمانی خاتمه یابد که به یک کار خاص برسد. در عوض، ما باید از یک محدودیت به عنوان یک معیار خاتمه استفاده کنیم. با توجه به اینکه Q-learning عملی را با حداکثر مقدار در هر حالت انتخاب می کند، می توانیم رویکرد مشکل خود را به صورت زیر تغییر دهیم:

(۱) هر حالت عملی را با کمترین مقدار در ردیف مربوطه از جدول Q انتخاب می کند، یعنی عمل با کمترین زمان مصرف شده. جدول اولیه زمان مصرف شده توسط هر کار را ذخیره می کند و اطمینان حاصل می کند که انتقال حالت یک عمل را با حداقل زمان انتخاب می کند.

(۲) طبق الگوریتم اصلی یادگیری Q، هر بار در جدول Q با حداکثر مقدار در یک ردیف برای یک عمل مطابقت دارد. در این حالت، جدول اولیه ۱۰۰ منهای زمان صرف شده توسط آن کار را ذخیره می کند. با این حال، این مربوط به انتخاب عمل با بیشترین مقدار است، که در مدل ما نشان دهنده کاری است که در واقع زمان کمتری را می گیرد. این انتقال حالت را کامل می کند. در این مقاله رویکرد دوم را اتخاذ می کنیم.

۳٫۳٫ تعریف ماتریس پاداش R

با توجه به نمودار ماشین لباسشویی AND/OR که قبلا ذکر شد، مورد شامل ۱۳ کار است [

۲۷]، مربوط به مجموع ۱۳ حالت در الگوریتم است. هر حالت می تواند ۱۳ عمل داشته باشد، به این معنی که هر وظیفه می تواند از ۱۳ وظیفه برای انتقال حالت انتخاب کند. بنابراین، ما یک ماتریس دو بعدی ۱۳×۱۳ می سازیم. اگر به حالتی نرسید، مقدار موقعیت مربوطه را ۱- و اگر با خودش یکسان باشد، آن را ۰ قرار می دهیم. برای حالت هایی که می توان به آن رسید، مقدار را ۱۰۰ منهای جداسازی می کنیم. زمان صرف شده برای کار مربوطه از شکل، مشخص است که وظیفه ۱ می تواند به وظایف ۲، ۳ و ۴ برسد. از آنجایی که حافظه آرایه با زیرنویس ۰ شروع می شود، مقادیر را تنظیم می کنیم. [۰,۱]، [۰,۲]، و [۰,۳] در آرایه به مقادیر ۱۰۰ منهای زمان جداسازی قطعات صرف شده برای وظایف ۲، ۳، و ۴، به ترتیب. این تضمین می کند که عامل می تواند به طور موثر یاد بگیرد. در پایان، در هر مرحله، موقعیت با بیشترین مقدار در جدول Q انتخاب می شود و وضعیت مربوطه، شماره کار است که در مرحله بعد انجام می شود. این کار یادگیری مثال را کامل می کند و محیط را نشان می دهد. از این مثال حسابی می توان روش تعریف ماتریس را خلاصه کرد

آر = [

] با استفاده از روش زیر باید یاد گرفت:

بر اساس این تعریف،

آر ماتریس ماشین لباسشویی به شرح زیر است:

بر اساس ماتریس به دست آمده از نمودار AND/OR، عامل چندین بار با محیط تعامل دارد و محیط مقادیر بازخوردی را برای عامل ارائه می دهد. این فرآیند منجر به یک جدول Q می شود که مقادیر Q را برای اقدامات قابل انتخاب در هر حالت ذخیره می کند. با استفاده از الگوریتم حریص، عمل مربوط به بزرگترین مقدار Q را از حالت شروع انتخاب می کنیم تا به حالت بعدی برسیم که نشان دهنده کار بعدی است. این انتقال حالت را کامل می کند. الگوریتم زمانی خاتمه می یابد که محدودیت بهره برآورده شود. سپس راه حل بهینه بر اساس نتایج به دست آمده خروجی می شود.

روند یادگیری الگوریتم بر اساس جدول اولیه به شرح زیر است: با فرض ۲۰۰۰ مرحله یادگیری، نرخ یادگیری

= ۰٫۵، و مقدار کاهش بازگشت آتی

= ۰٫۹٫ پس از آموزش، ماتریس زیر به دست می آید:

در جدول مشاهده می کنیم که حداکثر مقدار در ردیف اول ۲۵۶٫۷ است که مربوط به عمل ۲ است. بنابراین، مرحله بعدی انتخاب وظیفه ۲ برای جداسازی است. با حرکت به ردیف دوم، حداکثر مقدار ۱۷۸٫۶ است، بنابراین ما عمل ۵ را برای انتقال حالت، مربوط به وظیفه جداسازی ۵ انتخاب می کنیم. با حرکت به ردیف پنجم، حداکثر مقدار ۹۴ است، بنابراین عمل ۱۱ را برای انتقال وضعیت، مربوط به وظیفه ۱۱٫ هنگامی که ما به کار ۵ جدا می شویم و سود جداسازی را برآورده می کنیم، معیار توقف الگوریتم را برآورده می کنیم و در نتیجه جواب بهینه را به دست می آوریم. در این مرحله، دنباله جداسازی قطعات مربوطه ۱ → ۲ → ۵ است.

۴٫ معرفی مورد و تجزیه و تحلیل نتایج

این بخش شش مورد مختلف از نمودارهای AND/OR را معرفی میکند و نحوه ادغام آنها در الگوریتم یادگیری Q را توضیح میدهد. هدف رسیدگی به مواردی با اندازه های مختلف برای پاسخگویی به ویژگی های مشکل و در نظر گرفتن سناریوهای مختلف است. نتایج اجرای مربوطه بر اساس اندازه های مختلف مورد تجزیه و تحلیل می شود و نتیجه گیری می شود [

۲۸]. مدل با استفاده از الگوریتم Q-learning و IBM ILOG CPLEX حل شد. الگوریتم Q-learning در پایتون کدگذاری شد و بر روی رایانه ای با پیکربندی: Intel(R) Core(TM) i7-10870H @ 2.30 و سیستم عامل ویندوز ۱۰ پیاده سازی شد.

برای مورد اولیه، یک مثال کوچک شامل ۱۳ وظیفه مربوط به قلم توپ برای آزمایش استفاده می شود. [

۲۹]. نمودار AND/OR برای این جعبه خودکار کوچک در تصویر نشان داده شده است

شکل ۵ در زیر، به عنوان مورد ۱ نشان داده شده است.

شکل ۶ نمودار قطعه مته چکشی را نشان می دهد که اجزای اصلی آن را می توان مشاهده کرد.

در حالت دوم یک خودکار با ۲۰ کار در نظر گرفته شده است. از آنجایی که زیرمجموعه ۱ می تواند هم وظیفه ۱ و هم وظیفه ۲ را انجام دهد، یک کار اضافی ۰ به الگوریتم معرفی می شود. وظیفه ۰ می تواند به وظایف ۱ و ۲ برسد. در نتیجه، ۲۱ کار و ۲۴ مجموعه فرعی وجود دارد که منجر به ساخت یک ماتریس دو بعدی ۲۱×۲۱ می شود. این مورد به عنوان مورد ۲ مشخص می شود [

۳۰,

۳۱]. برای مورد سوم از دستگاه کپی کمی بزرگتر با ۳۲ کار استفاده شده است. طبق نمودار AND/OR، زیرمجموعه ۱ می تواند وظایف ۱، ۲، ۱۶ یا ۲۸ را انجام دهد. بنابراین، وظیفه ۰ در الگوریتم ساخته شده است و به آن اجازه می دهد تا به وظایف ۱، ۲، ۱۶ و ۲۸ برسد. ساخت یک ماتریس ۳۳ × ۳۳ برای یادگیری الگوریتم. از این پرونده به عنوان مورد ۳ یاد می شود [

۳۲,

۳۳]. در مورد چهارم، روتوری در نظر گرفته شده است که دارای ۱۵ وظیفه و ۱۷ مجموعه فرعی است. یک ماتریس دو بعدی ۱۵×۱۵ بر اساس نمودار AND/OR برای یادگیری الگوریتم ساخته شده است. از این پرونده به عنوان مورد ۴ یاد می شود [

۳۴,

۳۵]. مورد پنجم شامل یک رادیو کمی بزرگتر با ۳۰ کار و ۲۹ مجموعه فرعی است. برای فعال کردن کار ۰ برای رسیدن به وظایف ۱ و ۲، یک ماتریس دو بعدی ۳۱ × ۳۱ برای یادگیری الگوریتم ساخته شده است. این مورد به عنوان مورد ۵ مشخص می شود [

۳۶,

۳۷]. در نهایت، یک نمونه بزرگ از مته چکشی با ساختار جزئی برای مورد ششم استفاده شده است. این کیس شامل ۴۶ وظیفه و ۶۳ مجموعه فرعی است [

۳۸,

۳۹]. یک ماتریس ۴۶ × ۴۶ برای یادگیری الگوریتم ساخته شده است. از این پرونده به عنوان پرونده ۶ یاد می شود.

میز ۱ شرح مفصلی از همه موارد، از جمله پارامترهای مختلف برای محصولات کوچک، متوسط و بزرگ به ترتیب ارائه می دهد.

جدول ۲ تنظیمات پارامتر الگوریتم را برای هر محصول توضیح می دهد.

جدول ۳ نتایج الگوریتم برای هر مورد و نتایج به دست آمده با حل کننده CPLEX را نشان می دهد.

جدول ۴ مقایسه ای از نتایج الگوریتم یادگیری Q و الگوریتم SARSA برای شش مورد ارائه می کند. قسمت آخر از

جدول ۴ نتایج مقایسه بین الگوریتم یادگیری Q بهبود یافته و الگوریتم اصلی یادگیری Q را برای شش مورد ارائه می دهد.

شکل ۷ همگرایی تابع هدف را برای الگوریتمهای Q-learning و Sarsa در مورد ۶ نشان میدهد. از آنجایی که تابع هدف این فصل با هدف به حداقل رساندن حداکثر زمان جداسازی قطعات در حین اطمینان از سود جداسازی مشخص است، مقادیر کوچکتر تابع هدف ترجیح داده میشوند. از نمودار، می توان مشاهده کرد که پس از تثبیت، مقدار تابع هدف الگوریتم یادگیری Q کوچکتر است، که نشان می دهد راه حل های امکان پذیر بهتری به دست می آورد. علاوه بر این، پایداری الگوریتم یادگیری Q نسبت به الگوریتم سارسا برتری دارد.

شکل ۸ همگرایی خطای TD را برای الگوریتم های Q-learning و Sarsa نشان می دهد. می توان مشاهده کرد که الگوریتم یادگیری Q پس از تقریباً ۱۲۵۰ مرحله آموزشی به همگرایی می رسد، در حالی که سارسا حتی پس از ۲۰۰۰ مرحله ناپایدار می ماند.

از جداول بالا، مشهود است که الگوریتم یادگیری Q بهبود یافته در واقع می تواند راه حل بهینه را پیدا کند و زمان اجرای آن بسیار سریعتر از CPLEX در مقیاس های مختلف موردی است. علاوه بر این، میتوانیم در جدول ببینیم که زمان اجرای CPLEX به صورت خطی با مقیاس مورد رشد میکند، در حالی که زمان اجرای الگوریتم یادگیری Q با مقیاس مورد افزایش مییابد. زمان اجرای الگوریتم یادگیری Q به طور قابل توجهی با افزایش اندازه پرونده تغییر نمی کند و تفاوت ها ناچیز است و از ۰٫۰۴ ثانیه تا ۰٫۶۱ ثانیه متغیر است. علاوه بر این، با توجه به نتایج پنج مورد اول، حداکثر زمان اجرای الگوریتم تنها ۱۴ درصد از زمان اجرای CPLEX است که درصد کمی از زمان است. حتی در مورد دوم، تنها ۱٪ است که نشان میدهد الگوریتم میتواند راهحل بهینه را در مقایسه با CPLEX که برای شرکتها یا کارخانهها حیاتی است، کارآمدتر پیدا کند. نکته مهم این است که از نتایج تجربی می توان دریافت که در موارد با مقیاس کوچک و متوسط، CPLEX راه حل بهینه مشابه الگوریتم را ارائه می دهد.

با این حال، زمانی که آخرین مورد در مقیاس بزرگ با ۴۶ کار انجام میشود، CPLEX با مشکل سرریز حافظه مواجه میشود. میتوان دید که CPLEX بسیاری از ردیفها را حذف کرده و مرزها را بارها بهبود بخشیده است. با این حال، به دلیل اینکه مقیاس مثال محاسبه خیلی بزرگ است و RAM در محیط در حال اجرا کافی نیست، حافظه کافی برای ادامه ساخت داده های مربوطه در آینده وجود ندارد. مقیاس راه حل برای مورد بسیار بزرگ است، و راه حل های ممکن بیش از حد وجود دارد، که یافتن راه حل بهتر را غیرممکن می کند، در حالی که الگوریتم یادگیری Q می تواند راه حل بهتری ارائه دهد. این نشان می دهد که الگوریتم یادگیری Q بهبود یافته در واقع می تواند DLBP را حل کند و راه حلی که ارائه می دهد بهینه است. در آینده، مقیاس محصولات بازیافتی ما ممکن است بزرگتر شود و ممکن است شامل محصولات بزرگی شود که باید از هم جدا شوند مانند موتورها و موتورسیکلت های مستعمل. در این مورد، CPLEX ممکن است برای یافتن راهحل بهتر مشکل داشته باشد، اما الگوریتم پیشنهادی میتواند یک راهحل عملی را در مدت زمان بسیار کوتاهی پیدا کند. این ثابت میکند که نه تنها میتواند مشکل بازیافت محصولات کوچک جدا شده بلکه مشکل بازیافت محصولات بزرگ مورد استفاده را نیز برطرف کند. الگوریتم پیشنهادی در هنگام حل DLBP محدود به اندازه مورد محاسباتی نیست و میتواند یک راهحل بهینه را در زمان کوتاهتری ارائه دهد.